天天新闻

天天在线汽车

天天在线文旅

天天财经116

天天在线App

天天新闻

天天在线汽车

天天在线文旅

天天财经116

天天在线App

当算力、芯片、雷达、800万像素等电子科技类产品的多维度表述被越来越多用在汽车上时,意味着汽车的科技属性越来越高,简单理解是汽车越来越聪明,离自动驾驶更近一步。

芯片、算力、算法这些词汇以及所代表含义对绝大多数人来说是云山雾绕,和汽车结合之后更不明所以,好在汽车是一个实实在在的产品,通过体验能感受到科技带来的变化。智能语音应该是最容易感受到的,相比此前要一个字幕一个字母输入导航地址,现在一句话就可以解决问题,简单快捷的同时,准确率也更高。

当下的汽车和手机一样,一代比一代智能,以前五六年车型换代,目前在智能化方面迭代速度甚至是一年或是几个月。

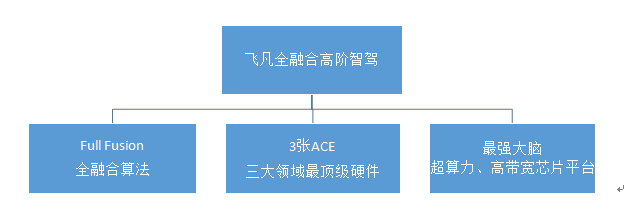

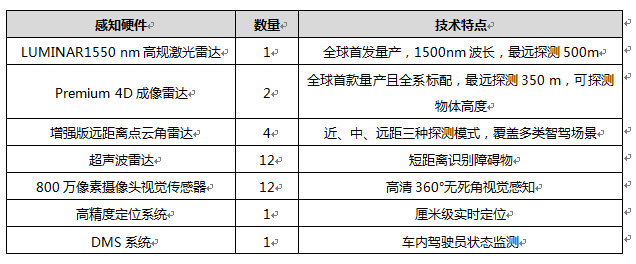

将于10月份上市的飞凡R7在智能科技方面搭载了众多硬件,并匹配了相应的算法,其称为全融合高阶智驾系统。全融合高阶智驾系统由全融合算法、33个感知硬件和芯片平台组成。

33个感知硬件

1个高规激光雷达

激光雷达补足了视觉方案受光线影响较大、毫米波雷达探测轮廓准确性不足的问题,可以完成精准三维几何位置、尺寸、类型识别,同时进行三维感知建图,以及路沿、通用障碍物的探测。

相比目前行业主流激光雷达约200米的探测距离,飞凡R7装备的激光雷达采用光纤激光放大方式,最远探测距离高500米。在对智驾更有价值的10%的反射率下,仍可实现250米最远探测距离。

2个4D成像雷达

4D指距离、速度、水平方位角、垂直高度。相较于传统毫米波雷达,4D雷达通过增加发射、接收通道的个数,输出距离、水平、垂直定位高度和速度四个指标,即在3D雷达基础上增加了“探测物体垂直高度”,从而提升了静态障碍物的检测率,并可对其进行分类;

相较普通毫米波雷达210米的探测距离,其4D成像雷达探测距离最远350米;

与光学传感器不同,4D成像雷达传感器通过电磁波主动感知,即使在天气和光照条件欠佳的情况下,4D成像雷达仍可正常运作。

4D成像雷达产生类似激光雷达的“点云”:对于每个点,不仅知道X、Y和Z,还可以直接得到速度值,并持续跟踪这些数据变化,4D毫米波雷达点云可以直接成像,具备超高分辨率,配合机器学习算法可以有效解析目标的轮廓、类别等,并且支持点云和目标同步输出。

4个增强版远距离点云角雷达

增强版远距离云角雷达采用水平和垂直方向的专业阵列式天线设计、布局和信号多收多发功能,实现了近中远自适应的探测模式、更广的视场角、更准确的探测精度、更远的测量距离和更高维度的探测能力。具备超高分辨率,配合机器学习算法可以有效解析目标的轮廓、类别等。

12个超声波雷达

12个高清摄像头

前向3个800万像素摄像头,后向1个800万像素摄像头,4个300万像素周视摄像头、4个300万像素环视摄像头,可以360°感知车辆周围,对动态人车交通参与者和静态车道线、地面标识、红绿灯、限速标识等交通要素感知内容更细。同时,高分辨率摄像头还具备更高的动态范围和更优的LED频闪消除功能。

1个高精度定位系统

厘米级精准实时的车辆定位,全要素高精度地图信息。

1个DMS系统

配合DMS驾驶员监测系统和电容式HOD脱手监测,对驾驶员安全使用智驾功能提供保障。

芯片平台

2颗英伟达Orin X芯片

英伟达Orin X芯片采用7nm工艺,单颗芯片算力达到254 TOPS(1TOPS每秒运算1万亿次);

搭载升级的Arm Cortex-A78AE车规增强型图象处理器,12核中央处理器,具备更强的计算与扩展能力;

搭载深度学习加速器, 专为卷积神经网络推理应用设计,相比上一代性能提升9倍;

搭载可编程视觉加速器,支持4个英伟达最新第2代可编程视觉加速器,进一步增加智驾系统对目标物体的识别和跟踪能力。

千兆以太网主干通信

搭载的千兆以太网主干通信,主要采用4路千兆以太网与9路百兆以太网组合,单线数据传输速度达到传统CAN总线的2000倍。面对远超人脑处理能力上限的海量感知信息,与英伟达Orin X芯片和全融合算法配合,可在毫秒级内完成感知、计算、决策、执行等一整套应急反应。

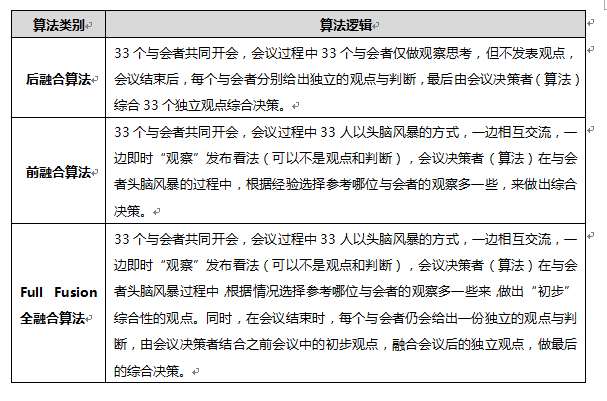

全融合算法

全融合算法将前融合组合、多任务、多特征网络输出的探测结果,与后融合多个传感器独立输出的探测结果进行综合,实现前融合和后融合的全要素融合,确保结果更快、更安全、更完备和更高置信度。

前融合是指所有传感器基于算法,将来自激光雷达、摄像头和毫米波雷达的不同原始数据统一处理,相当于一套环绕全车360°的传感器,通过一套算法,完成整个感知过程。不过,前融合对不同类型源数据的时效性要求高,所以对硬件算力有更强要求。同时,会出现误判或失误,需要冗余的系统进行验证。

后融合是指不同的传感器分别通过不同的算法进行独立感知,完成识别后生成独立的信息。不过,后融合感知框架中,单一类型的传感器因自身能力限制,特定条件下可能发生漏检或误检。如视觉传感器,可根据颜色、纹理、标识线、文字内容、红绿灯、交通指示信息、转向灯等,来判断物体的类型,但不擅长判断距离和位置;雷达是以三维坐标轴确定一个个点的坐标,然后由点组成轮廓,所以更擅长判断距离、速度、角度等,而不擅长判断颜色和识别纹理,也不能识别文字信息。所以需要配置不同类型的传感器才能保障在不同环境工况下维持有效的智驾感知功能,不同类型传感器的识别结果需要互相验证,才能达到更高的置信度。

全融合算法是将前融合和后融合两个过程同步进行,对视觉、毫米波、激光雷达独立的感知结果进行后融合,同时综合激光/毫米波+图像的前融合结果进行全要素全观测周期融合,并且会在领航功能中综合高精度地图信息,通过这些环境要素信息的全融合,实现对辆周围环境信息的精确测量和准确判断,给后端的功能实现提供完备的复杂环境模型信息。全融合算法可以简单理解为,整个智驾系统的决策行为为一场会议,行为决策模块视为会议决策者,33个感知硬件视为与会者。

飞凡R7智驾系统亮点

匝道全域增强识别

飞凡R7可通过更远距离和更精准的综合感知,提前识别匝道三角区域,从而有更充裕的时间提前进行变道准备。同时能够实时识别前后车辆的行驶状态与趋势等周围路况。

超灵敏静态路障感知

飞凡R7的激光雷达,可提前探测最远500米处的施工区域,并精准识别静态障碍物的三维几何位置、尺寸和类型,即便只有雪糕筒或施工提示牌也可提前精准识别,并通过预测和决策模型,快速反应实现提前避让。同时,4D成像雷达可实现精准速度和加速度测量,与高清摄像头的全融合,能在探测中除目标之外,还能识别路沿、道路分叉口、自由空间等。

雨雪雾天超视距识别

飞凡R7的4D成像雷达拥有全天候适应能力,在团雾场景下仍可穿透团雾识别前方行车环境和障碍物,即使雨雾雪粉尘等恶劣天气下不受光线影响。

预感知避让/礼节变道/侧向安全距离弹性保持

飞凡R7的高感知传感器,实现360°无死角的道路感知,从而实时监测变道冲突场景,当发现有其他车辆同时变道并可能产生冲突时,可采取保守的安全策略,保持与周围车辆的安全距离,让冲突车辆先行,随后再完成变道等动作。